郑州网站建设教你如何分析日志文件?

发布时间:2023-08-04 08:58:11 | 发布者:往流科技

第一部分日志文件分析

一般我们可以通过ftp或者连接服务器,找一个名为logfiles的文件夹,里面有很多个文件,可能大家有的人看不懂,不过没关系,咱们可以借助第三方工具爱站,爱站工具包—日志分析—选择文件—开始分析,可以清楚清楚的看到有哪些搜索引擎哪一天来爬取过我们的哪些页面。在这咱们需要注意的几个事项:

①如果你网站内容经常不更新,那么蜘蛛来的频次会越来越少

②如果蜘蛛不来你的网站爬取了,那么很可能你网站被k了,网站被k也有多种原因(可能是网站被挂木马,也有可能是站长自己操作问题,后续在我的文章中会给大家详细介绍);

③搜索引擎爬取的时候空间打不开,也会导致搜索引擎爬取频率比较少

④是死链接,图片,动画太多,也会导致搜索引擎爬取频率过少或者不爬,因为搜索引擎是顺着链接爬取的,同时也无法抓取图片和动画,死链接太多,蜘蛛爬不下去了,就主动放弃不再爬取

⑤如果Roberts设置禁止全站被蜘蛛或机器人爬取,那么蜘蛛或机器人也不会再爬取

第二部分Roberts协议

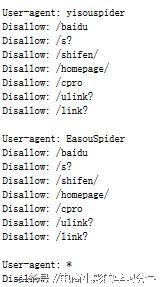

通常在根目录下,会有一个Roberts协议,Roberts协议是鉴于保护自己的网络隐私去写的一个协议,简单的理解:这个协议就是告诉蜘蛛或机器人你是否有权限爬取我的网站,以及你不可以爬取我的网站那一部分内容。咱们截取百度的Roberts协议中的一段来看一下,如图所示:网站建设之日志分析篇

咱们可以来看一下,在Roberts协议中,*这个符号表示“所有”的意思,user-agent:yisouspider咱们就可以理解为百度允许一搜来抓取它的东西,Disallow是不允许的意思,那下面这句:Disallow/baidu意思就是不允许抓取baidu这个文件下的所有内容,其他的同样。最后一句:

“User-agent: *

Disallow: /”

上面这句代码的意思就是:除了我上面所列举出来的这些蜘蛛或机器人,其他的蜘蛛或机器人都不允许抓取我网站上的任何东西,违者可以追究法律责任。一般一个蜘蛛或机器人去爬取一个网站,首先就要爬取网站Roberts文件,然后遵守协议去爬行。